Si alguna vez nos hemos planteado qué repercusiones negativas podría tener la inteligencia artificial en nuestra sociedad, los Deepfakes son un claro ejemplo. Ya sabíamos que esta nueva tecnología podría usarse para cosas tan preocupantes como quitarles el trabajo a los humanos, pero muchos no se pararon a pensar que también serviría para engañar y crear confusión entre la sociedad.

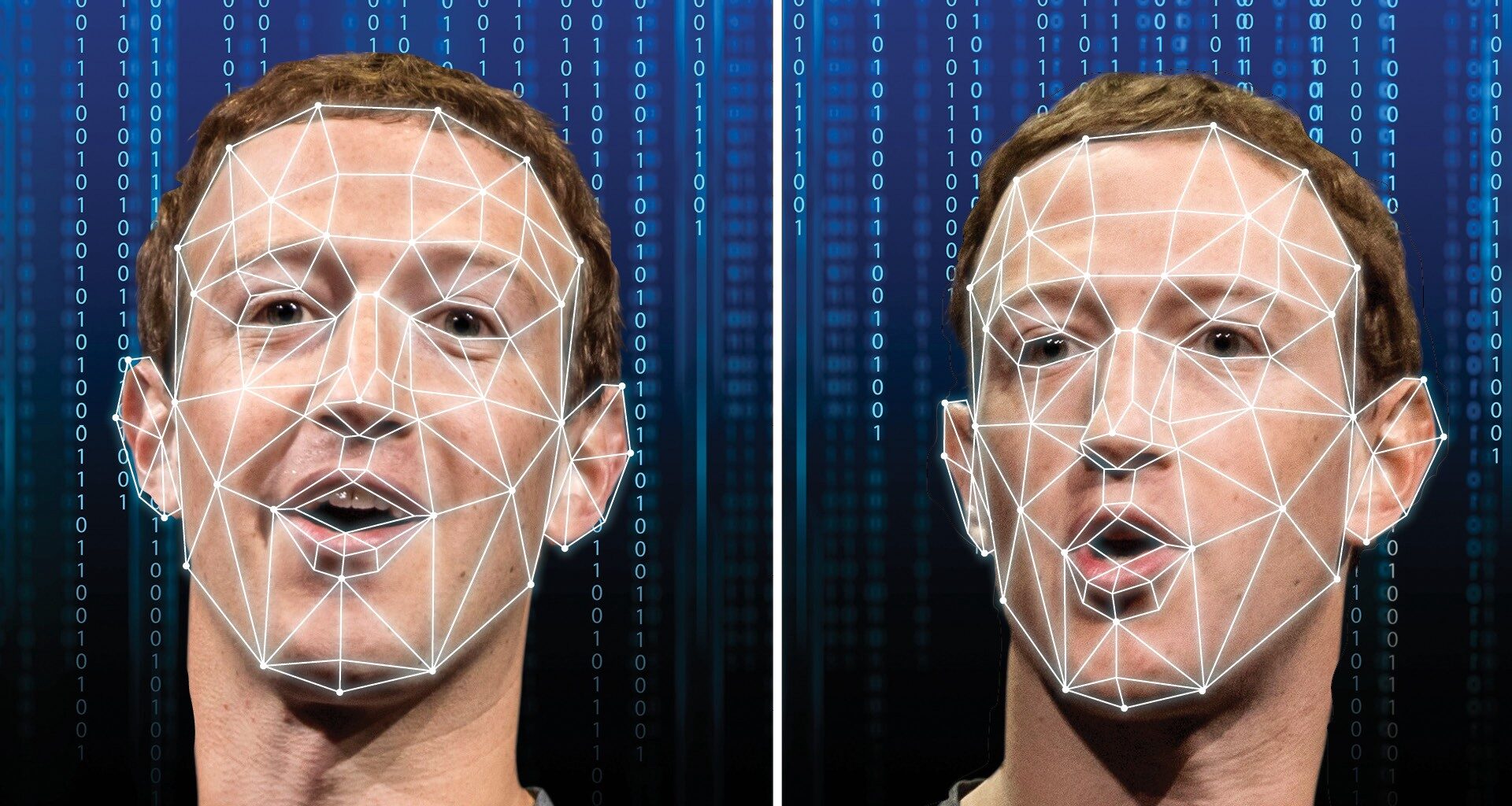

La palabra Deepfake es una composición de los términos deep learning y fake, es decir: aprendizaje profundo, una de las ramas de la inteligencia artificial, y la palabra falso. El nombre le viene perfecto, ya que de lo que estamos hablando es de una tecnología basada en la Inteligencia Artificial que consigue superponer el rostro de una persona en el de otra y falsificar sus gestos para hacernos creer que están haciendo o diciendo algo que no ha pasado en realidad.

Los primeros vídeos falsificados con esta tecnología se empezaron a ver hace varios años. En ellos se habían manipulado los rostros de varias actrices internacionales, como Natalie Portman o Emma Watson, para que encajaran en cuerpos de actrices de la industria pornográfica.

Con el paso del tiempo, esta tecnología ha ido evolucionando y sus resultados son cada vez más sorprendentes (y preocupantes), hasta el punto en que se han conseguido crear vídeos de los principales líderes del mundo dando un discurso completamente falso.

Lo que antes requería de cientos de horas de edición, con equipos y expertos trabajando en ello, ahora un software en pocas horas puede crearlo de manera muy creíble. Ya es bastante difícil controlar las fake news o noticias falsas que corren por la red, sobre todo en épocas electorales, como para encima sumarles ahora este tipo de engaños.

¿Qué pasa cuando no puedes identificar un contenido falso?

Una serie de vídeos en los que un impostor se hace pasar por Tom Cruise con ayuda de herramientas de deepfake han tenido más de 11 millones de visualizaciones en TikTok, donde infinidad de usuarios reconocen que son incapaces de distinguir si el contenido es falso.

El perfil viral ha traído de vuelta la preocupación por este mecanismo, que permite falsificar identidades de manera super detallada, gracias a la inteligencia artificial, y que cada vez se utiliza más en campañas publicitarias, pero también en estrategias de propaganda y desinformación.

Los vídeos del falso Tom Cruise comenzaron a publicarse la semana pasada con una publicación en la que su doble practicaba golf.

“Si les gusta lo que están viendo, esperen a lo que viene a continuación”, decía el falso Cruise antes de replicar su conocida risa, con el mismo tono de voz.

Tom Cruise, el real, no ha participado en ninguna de las publicaciones, que aún no han sido retiradas ni señaladas por TikTok.

La red social explica en su reglamento que elimina los contenidos falsos cuando su objetivo es engañar a los usuarios, pero como en este caso el perfil al que se han subido tiene como nombre de usuario @deeptomcruise, no ve necesidad de hacerlo, aunque tal y como demuestran los comentarios, son muchos los usuarios que no se han percatado de ese detalle y han creído lo que veían.

Follow this

Follow This es una serie estadounidense de mini documentales producida por BuzzFeed. El programa fue lanzado en Netflix el 23 de agosto de 2018. Cada episodio del programa se centra en un tema diferente, con tópicos que incluyen la intersexualidad, los derechos de los hombres y los sexbots.

En el séptimo episodio de la primera parte de esta serie, nos encontramos con el episodio: The Future of Fakes. En él, Charlie Warzel, reportero, explora el futuro de las noticias falsas y la tecnología detrás de los “deepfakes”

Charlie inicia utilizando esta tecnología para imitar a Donald Trump y, la calidad del vídeo, llega a ser espeluznante. ¿Qué sigue, si puedes manipular la cara del presidente y crear un vídeo en el que le declare una guerra nuclear a Corea del Norte? El futuro de esto es potencialmente desastroso

La manipulación de audio y video en internet son muy populares, se va desde el entretenimiento hasta las completas distopías y en el cine, ha escalado considerablemente.

Para ampliar el tema, Warzel entrevista a John Knoll, supervisor de efectos visuales y director creativo de Industrial Light & Magic, uno de los creadores originales de Adobe Photoshop, quien también trabajó como supervisor de efectos visuales en las precuelas de Star Wars y las ediciones especiales de 1997 de la trilogía original. John cuenta cómo se realizó el trabajo tecnológico de Tarkin, personaje de Star Wars que tuvieron que manipular digitalmente luego de que el actor que lo interpretaba, Peter Cushing, falleciera.

Creamos un modelo digital muy detallado de su cara y pasar por un proceso continuo de comparar a nuestro modelo con el material de archivo, hasta que sentimos que se parecía bastante.

John Knoll a Charlie Warzel

No todos pueden revivir a una persona, pero muchos sí pueden manipular y perjudicar la vida de otros.

Existen en la actualidad softwares que crean, por ejemplo, copias digitales de la voz. Con un micrófono, al leer frases predefinidas, el sistema crea un patrón que permite emitir cualquier palabra o frase con la voz registrada.

Todo esto suena demasiado emocionante, pero, ¿qué pasa cuando no se utiliza éticamente?

En Follow this, el reportero de Buzz Feed entrevista a una mujer que se vio realmente afectada por esto. Era Abril de 2011, acababa de cumplir 21 años y un día comenzó a recibir muchos mensajes por Facebook, en ellos le hablaban de unas fotos “inapropiadas” que habían de ella, en línea. Se trataba de una imagen manipulada por Photoshop que contenía el rostro de la afectada y los senos al desnudo de alguien más.

El departamento de policía no pudo hacer nada en aquel momento.

Sin embargo, no es el único tipo de engaño que puede hacerse con esta tecnología.

En marzo de 2019, el director de una empresa de energía alemana, ubicada en el Reino Unido, recibió una llamada que le sorprendió. En un tono enérgico y apresurado, el CEO de la compañía ordenó una transferencia inmediata de 243.000 dólares a una cuenta corriente en Hungría. La razón, argumentó, era el plazo para pagar una cuota de última hora.

Debido al tono de voz, el director hizo la transferencia. Unos momentos más tarde, su teléfono sonó nuevamente y era una vez más el CEO, quien le pidió que realizara otro movimiento similar. Sospechoso, colgó el teléfono y se puso en contacto directamente con el número personal del ejecutivo, quien negó haber hecho la solicitud. Mientras estaba en la llamada, recibió otra llamada del “falso jefe”, lo que confirmó la sospecha: la voz del hombre había sido manipulada digitalmente.

El caso salió a finales de agosto y fue presentado por la francesa Euler Hermes, compañía de seguros contratada por la compañía alemana (que no fue identificada) responsable de cubrir todos los costos perdidos con la estafa.

Hablemos de ciberseguridad

Los ciberdelincuentes son una especie en constante evolución, que se adapta continuamente a las circunstancias, siempre innovando. Infortunadamente, no puede decirse lo mismo de las empresas en su empeño por frustrar sus planes, y eso que es mucho lo que se juegan en el envite. Un 78% de las compañías confía poco en sus mecanismos de seguridad, lo que no es de extrañar, a cuenta de que gran parte de ellas ni siquiera los chequea con frecuencia.

En el Perú existen muchas iniciativas de emprendimientos y gran parte de estos se basan en el desarrollo de negocios tecnológicos, como son las Fintech. De esta manera, las empresas se preocupan cada vez más por que sus modelos de negocios y sistemas sean concebidos –desde un punto de partida- considerando los distintos factores de riesgos, amenazas y regulaciones técnicas-legales.

Identificar, clasificar y priorizar estos factores son la clave en las etapas de diseño, definición de modelo de negocio, diseño de aplicaciones, diseño de seguridad, seguridad IT, etc. Esto es, seguridad como un todo y debe ser accesible desde las pequeñas hasta las más grandes empresas corporativas